获取推理结果坐标

-

通过rknn_lite模型推理结束后,获取推理结果的坐标(每个矩形框的四个点坐标)

-

这个后处理部分,暂时我们还没有提供,网络上先找找,目前yolov5正在TODO计划中。

-

@zhengbicheng 假如不考虑yolov5,我只需要推理结果的坐标。这个对我们很重要,后续功能的功能都是通过坐标来实现的

-

@ccjjww1222 每一个模型的输出设计都是不一样的,后处理也不一样,没办法提供一个通用的后处理代码。

-

@zhengbicheng 可能是我的描述不清楚,我们的模型依旧使用 yoloV5训练,用自己训练的模型,不是使用默认的yolov5 模型

yolov5有大概的时间计划不? 1个月?1个季度?还是明年 ? -

@ccjjww1222 我懂你的意思,你们就是把yolov5 clone下来训练一遍嘛。如果你们没有改动模型结构的话,在rknn上推理是会出错的。请先用这个仓库的yolov5进行训练:EASY-EAI-Yolov5

-

@ccjjww1222 yolov5计划在11月底前实现适配,下周可能会推出轻量级目标检测框架Picodet的适配,您可以尝试一下。

-

@zhengbicheng 好的

我参考了https://github.com/soloist-v/yolov5_for_rknn/blob/master/rknn_detect_yolov5.py里面的方案,画出来的矩形框位置不对,还是等等你们的吧。

模型训练目前先不急,我先把矩形框位置画对了,再训练 -

@ccjjww1222 这个yolov5应该是没问题的呀,你训练的yolov5是哪个版本的yolov5?

-

@zhengbicheng

通过https://github.com/rockchip-linux/rknn-toolkit/tree/master/examples/onnx/yolov5/yolov5s.onnx转换的。

另外一个事情,我用来测试的图片分辨率是810 X 1080,它有问题,

但是我接入摄像头,就没啥问题,摄像头每一帧的图片是480 X 640。

代码这边:https://github.com/jianwei/machine99/blob/main/detect/RKNN/detect.py (模型我没有上传) -

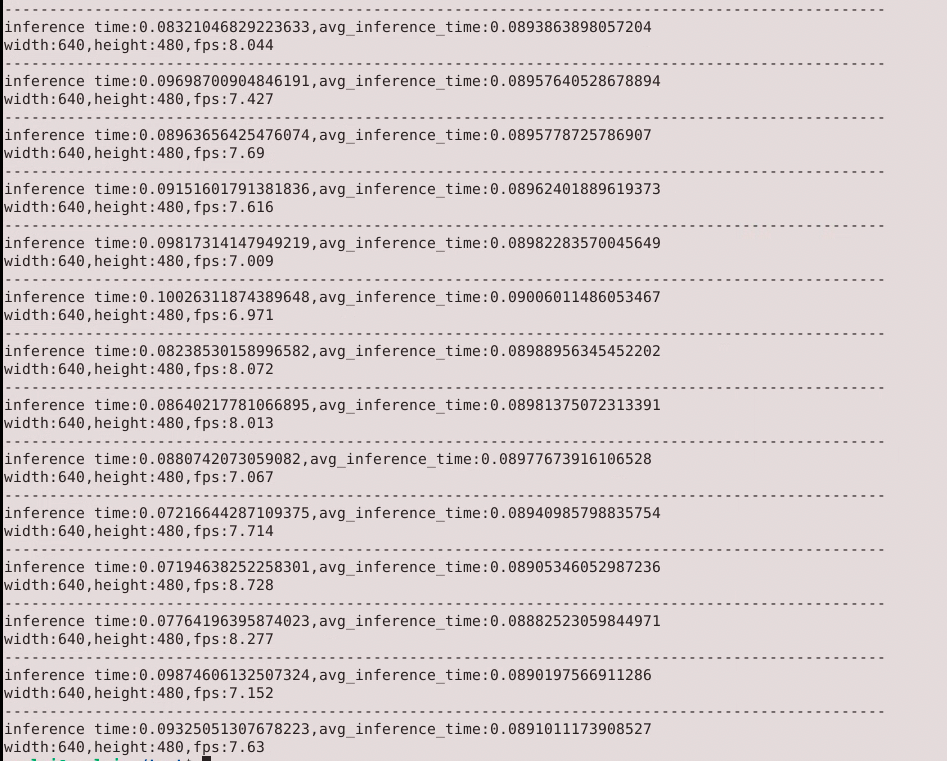

@zhengbicheng 这个是我摄像头推理的时间:

inference time:当前这一帧的推理时间

avg_inference_time:以上所有帧平均推理时间

width:宽

height:高,

fps:fps

这样的推理时间正常不 ?

. -

@ccjjww1222 正常,确实就是100ms左右

-

有问题无非两种情况。

- 第一种情况是模型本身就有问题。

- 第二种情况是模型没问题,rknn推理有问题。

排查的方法有两种。

- 第一种:针对RKNN推理精度问题,rknn-toolkit提供了连板调试的方法,但是我们还未开放这个方法。

- 第二种:请先用onnxruntime跑一遍onnx模型的推理结果,如果onnx推理出来的结果出错,说明是模型本身的问题。如果onnx推理没错,rknn错了,你再留言。

针对这个仓库的话,RKNN精度应该是没问题的,这个RK那边已经测试过了。只可能是模型不匹配,毕竟不可能100%都检测出来。

-

@zhengbicheng said in 获取推理结果坐标:

第一种:针对RKNN推理精度问题,rknn-toolkit提供了连板调试的方法,但是我们还未开放这个方法。

这个功能会开放吗,是硬件的更改吗?